Psychologie en data science

Walter Diele • 22 maart 2021

Wat als de complexiteit groter wordt dan je aankan

Soms popt er in mijn hoofd een link op tussen de vakgebieden waar ik in thuis ben. Nu houd ik mijn data science kennis veel beter bij dan mijn psychologie kennis, maar ik zag van de week een psychologie-professor een verhaal vertellen over geestesziektes waarbij ik moest denken aan twee veel gemaakte fouten in data science.

Zijn stelling was dat alle mentale aandoeningen dezelfde oorzaak hebben. Dat is natuurlijk wat te generiek gesteld, maar om een punt te maken vond ik het wel mooi. Zijn punt was dat als de mentale belasting op iemand blijft groeien (de complexiteit zo verhoogd wordt dat er geen uitweg gezien wordt), het breekt op het zwakste punt bij die persoon. Bij de een wordt het een psychose, de ander een eetstoornis, bij een derde een depressie, etc). Maar de oorzaak is een complexiteit die niet meer te overzien is.

Toen moest ik denken aan een te grote complexiteit in data science en waartoe dat leidt. Ik denk dat er twee effecten zijn.

1. Data scientists die modellen maken die niet meer te snappen zijn voor anderen.

Gelukkig is er in veel rollen binnen een organisatie nu interesse in de mogelijkheden (en de gevaren) van het gebruik van data en modellen. Maar dat betekent wel - in de psychologie analogie- dat de complexiteit ervan onder hun breekpunt moet zitten. Anders krijgen ze geestesziektes als ‘we verbieden alle modellen’, ‘alle algoritmes moeten centraal geadministreerd worden’ en ‘persoonskenmerken mogen niet opgeslagen worden’. Veel te rigoureuze maatregelen om de complexiteit te reduceren tot een behapbaar niveau. Op de weegschaal van wat kan-je-aan versus de belasting, is dat de belasting naar beneden brengen. Veel beter is het om de wat-kan-je-aan kant van de weegschaal te vergroten door in brede kring aan voorlichting en opleiding te doen. Niet om van juristen of managers data scientist te maken, maar om de complexiteit die ze aankunnen te vergroten zodat het niet breekt op de zwakste plek met gekke (interne) regelgeving tot gevolg.

2. Data scientists die de organisatie te complex vinden

Het tweede effect van hetzelfde fenomeen ligt bij de data scientist. Als je lekker aan het modelleren bent, met je hoofd in de code en de data zit, sluit je je af van rest van de wereld. Dat is nodig om iets voor elkaar te krijgen. Een kantoortuin waarbij je elke 10 minuten gestoord wordt, is voor een data scientist super irritant en niet productief. Maar dat betekent natuurlijk niet dat een data scientist in haar eentje een project succesvol kan afronden. Daar zijn veel collega’s bij nodig, van eindgebruikers in de business naar architecten naar legal en compliance tot IT. Waar dat voor een goede projectmanager geen punt is, kan deze complexiteit voor een data scientist boven het breekpunt zitten. De ‘ziektes’ die dat kan opleveren zijn bij voorbeeld: ‘ontwikkel projecten die nooit af komen’, ‘toepassingen waar niemand het onderhoud van kan doen’ en ’knappe toepassingen die geen echt probleem oplossen’. Om dit te voorkomen is het belangrijk om te herkennen dat deze complexiteit managen een vak apart is en het van het bordje van de data scientist af te halen. Als ik in gesprek ben voor een nieuwe ZZP klus en ze zoeken een manager data-science maar in het gesprek blijkt dat ze een mee-coderende voorman/vrouw zoeken, weet ik dat ze het belang van de organisatie complexiteit weghalen bij de data scientists nog niet doorhebben. Zullen ze wel veel prototypes hebben..

https://nos.nl/artikel/2262962-meisjes-stijgen-vaker-boven-schooladvies-uit-dan-jongens.html Mensen kunnen moeilijk los komen van hun eigen vooroordelen. Zelfs voor leraren, die het beste voor hebben met hun leerlingen, is het moeilijk om een objectieve inschatting te maken van het niveau van een leerling. Vanochtend berichtte de NOS dat meisjes structureel onderschat worden: er zijn meer meisjes die positief ‘verrassen’ op de Cito toets dan jongens, en na 3 jaar blijken meer meisjes dan jongens het ook echt beter te doen dan hun advies. Mijn vermoeden is dat er niet voor specifieke meisjes een verkeerde inschatting gemaakt wordt, maar dat de hele curve verschoven is. Helaas voor veel meisjes is door Corona het oordeel van de docent afgelopen jaar niet gecorrigeerd door de wat objectievere Cito-toets (die natuurlijk ook niet een zuivere schatter is voor middelbare schoolsucces, maar dat terzijde). Goede nieuws is natuurlijk dat we voor het schooladvies en hoe dat uitpakt, data hebben waaruit we kunnen concluderen dat we meisjes (en kinderen uit lagere sociaaleconomische klassen) structureel onderschatten. Dat biedt in principe de mogelijkheid om daarvoor te corrigeren. Als je als data scientist de relevante kenmerken/scores krijgt van alle kinderen en een voorspellingsmodel moet maken voor juiste schoolniveau, is een van de verklarende variabelen helaas dus het geslacht. Blijkbaar als je twee kinderen hebt die verder precies gelijk zijn op de kenmerken die je hebt, wordt de voorspelling van het echte niveau beter als je het meisje hoger inschat dan de jongen. Maar zo’n model is natuurlijk het schoolvoorbeeld van discriminatie; geen enkele zichzelf respecterende organisatie zal willen moeten toegeven dat kenmerken als geslacht en huidskleur gebruikt worden in voorspellingsmodellen. Maar wat nou als je het doet om de impliciete discriminatie die in de score van de andere kenkerken zit te corrigeren? Als ik ga fietsen neem ik altijd meer drinken mee dan dat ik denk dat ik nodig heb, omdat ik het steeds onderschat. Daarmee corrigeer ik mijn eigen inschatting; klinkt toch verstandig? Voor modellen ligt dat toch iets anders denk ik: als je wilt corrigeren voor allerlei kenmerken waarop je niet wilt discrimineren, zou je die kenmerken moeten bijhouden. Databases met gevoelige kenmerken van mensen bijhouden met de beste bedoelingen, pakt historisch gezien niet goed uit; als die data gehackt wordt, heb je een groter probleem veroorzaakt dat dan je had. Maar wat dan wel? Ik denk dat de Oudgriekse spreuk ‘ken uzelf’ op de tempel van Apollo is nog steeds actueel is. Kijk wat kritischer naar je eigen inschattingen, vooral als ze automatisch gaan; waarop baseer je die? Kan het ook anders zijn dan je denkt? En als je toevallig niet een docent bent: ongetwijfeld speelt hetzelfde effect ook op de arbeidsmarkt.

“We zijn afhankelijk van IT”. Deze zin zit al een paar weken in mijn hoofd. Het was een van de redenen die een potentiële nieuwe opdrachtgever gaf om af te zien van mij inhuren. Ik had een plan gemaakt en gepresenteerd om mijn visie op de oplossing te schetsen. Inhoudelijk zaten de echt moeilijke problemen natuurlijk weer in de data: hoe weet je wie wie is (mensen die in verschillende bonnen voorkomen matchen, wie vormt samen een huishouden, welke ZZP-er heb je ook privé als klant). En aan de zakelijke kant: eigendomsstructuren van complexe organisaties in de tijd goed bijhouden om op op het juiste aggregatieniveau te analyseren. Vaak zie ik dat bedrijven proberen dat rule-based goed te krijgen. Dat is natuurlijk kansloos: je weet het niet met zekerheid, dus je hebt een probabilistische koppeling nodig die je kan aanpassen als je meer info krijgt. En zelfs als je het magisch perfect zou hebben op een dag, is het de dag daarna al verouderd. Maar goed, inhoudelijke problemen kunnen complex zijn, daar kan je met de juiste mensen aan werken. Maar naast de techniek zijn er natuurlijk meer voorwaarden voor succes. Data wordt in alle silo’s van een organisatie gegenereerd; de analyse is vaak over de silo’s heen. En daar begint de ellende: wat wil je eigenlijk optimaliseren? Mag alle aandacht gaan naar het product waar je de meeste winst op maakt? De interne strategie van de organisatie verraadt vaak veel. Als bedrijven kreten nodig hebben als ‘as-one’ en ‘integrale klant benadering’, weet je dat daar dus het pijnpunt ligt. Als silo’s stiekem hun eigen doelstellingen willen optimaliseren, komt er van AI op de data over de silo’s heen natuurlijk niet veel terecht. Daarom echoot de zin ‘we zijn afhankelijk van IT’ ook nog in mijn hoofd: als de doelstellingen van IT en de andere organisatie onderdelen niet oplijnen op directieniveau, is het inderdaad misschien nog te vroeg om AI echt in productie te willen gaan gebruiken. Op zoek naar een andere nieuwe klus.

Dank je wel dat je een paar minuten van je leven besteedt aan het lezen van dit artikeltje. Voor elk stukje dat je leest, zijn er duizenden die je aan je voorbij laat gaan. Ik hoop dat je deze de moeite waard vindt, maar dat weet je pas achteraf. Maar waarom koos je ervoor dit aan te klikken? Het kan de titel zijn, maar misschien speelde mee dat ik het geschreven heb. Zelfs bij dezelfde boodschap, maakt het uit wie het zegt. Neem bij voorbeeld nooit financieel advies van iemand die minder vermogen heeft dan jij. De connotatie van een boodschap wordt gekleurd door de kennis en ervaring van de spreker. Niet alle kennis en overwegingen die geleid hebben tot een uitspraak zitten er in een bijlage bij, dus de mate van serieus nemen van de boodschap (of het überhaupt nog willen horen) is afhankelijk van de reputatie van de boodschapper. Ik moest hieraan denken toen ik een stukje las van Dockbite over tekstgeneratie met AI. Specifiek wat GPT-3 (Generative Pre-trained Transformer) inmiddels kan ten opzichte van BERT (Bidirectional Encoder Representations from Transformers). Ik heb de afgelopen 10 jaar veel (samen)gewerkt om met modellen en technieken bestaande teksten te classificeren en elementen en onderwerpen te extraheren. Dat is goed haalbaar en super nuttig en efficiënt. De maatstaf is voor nuttigheid is daar precision en recall (% terecht gevonden, onterecht niet gevonden). Dat is goed te meten met een test/validatie set aan data. Maar wat is de maatstaf bij tekst genereren? Tot nu toe in de artikelen die langs komen, lijkt de maatstaf de Turing test te zijn: als je teksten voorgeschoteld krijgt, zit je dan op de gok-kans bij het zeggen of het geschreven is door een mens of niet. Maar dat is niet de relevante maatstaf voor nuttigheid. Dat zegt alleen of je mensen iets op de mouw kan spelden zonder dat ze het door hebben. Als de tekst verder gaat dan het leesbaar maken van feiten (“Om 16.00 uur gaan Kamerleden in Nieuwspoort met elkaar in debat over sport, bewegen en gezond leven.”) denk ik dat de lezer er geen waarde aan gaat hechten. Niet omdat de zinsbouw niet deugt, maar omdat je de auteur niet kent en de inhoud niet in de context kan plaatsen van de kennis en ervaring van de auteur. Vraag jezelf af: zou je twee minuten willen besteden aan iets lezen dat het uit een algoritme komt? De Turing test is wel een hele lage benchmark voor het gebruiken van automatisch gegenereerde teksten door organisaties.

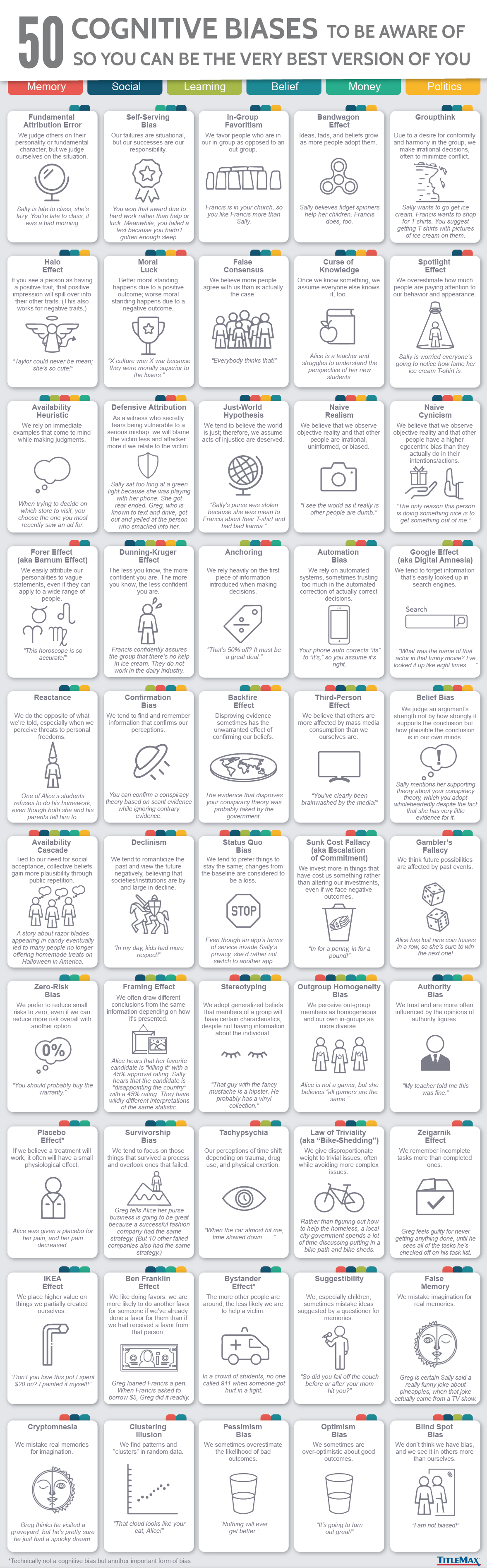

Wel eens een whatsapp-je gemaakt door steeds willekeurig een van de drie gesuggereerde woorden te kiezen? Dat levert misschien een grammaticaal correcte zin op, maar is natuurlijk inhoudelijk onzin, en al helemaal niet wat je had willen zeggen. Blind vertrouwen dat een algoritme een goede suggestie doet, is onverstandig. Maar omdat we iets kunstmatige intelligentie noemen (en ‘algoritme’ een moeilijk woord is), wordt vaak de uitkomst van een model zonder veel vragen te stellen gebruikt. Voorbeelden waarbij dat mis gaat zijn er legio, maar veel ervan die je in de media ziet zijn duidelijk en bijna grappig. Problematischer is het als het niet direct zo duidelijk is maar wel delen van de bevolking discrimineert. Mensen discrimineren; onze hersenen kunnen functioneren door allerlei cognitieve biases te gebruiken; en de besten onder ons zijn zich daar erg van bewust en proberen het effect daarvan te minimaliseren. Maar hoe dan ook levert ons gezamenlijke gedrag data op waar deze discriminatie ingebakken zit. Deze data aan modellen voeren leert de modellen op dezelfde manier te discrimineren. Valt daar dan niets aan te doen? Wel een beetje; er zijn technieken om data deels te corrigeren voordat het model erop getraind wordt. Gelukkig is daar toenemende aandacht voor, zeker onder de data scientists. Maar ook de top van organisaties heeft inmiddels pijnlijk ervaren dat zij verantwoordelijk zijn voor gebruikte modellen. Hopelijk gaat dat resulteren in meer betrokkenheid van management en model-governance binnen organisaties, zodat de deel-verantwoordelijkheden voor goed datagebruik op de juiste niveaus belegd worden in de organisatie. Maar kan je het ook omdraaien: kan je algoritmes gebruiken om menselijke discriminatie te detecteren? Eerlijk gezegd denk ik dat je daar niet heel ingewikkelde modellen voor nodig hebt. Een simpele kruistabel zal vaak voldoende zijn om misstanden aan te tonen. Als hoogopgeleide blanke Nederlandse man van in de 50 heb ik schokkend weinig ervaring in onheuse behandeling. Ik ben nog nooit staande gehouden door de politie, mijn koffers zijn nog nooit open gemaakt op een vliegveld, mijn kinderen worden op school ingeschat als slim (wat een self-fulfilling prophecy is), nooit een probleem gehad om werk te vinden enz. Natuurlijk allemaal terecht, maar geen toeval. En we kennen ook allemaal de voorbeelden van het effect van westerse versus niet-westerse namen op cv’s voor stages of banen; het veelvuldig aanhouden van donkere profvoetballers of rappers in dure auto’s; verschil in schooladvies per culturele achtergrond, kans op een huurwoning voor allochtonen versus autochtonen, ga zo maar door. Helaas zijn er geen moeilijke modellen nodig om een klein verschil in behandeling aan te tonen; het verschil is zo groot dat tellen voldoende is. Ook hier ligt de oplossing niet (vooral) bij de data scientist, maar bij de governance. Als bestuurders van organisaties verantwoordelijk gesteld zouden worden voor discriminatie als uit de data (tellingen) blijkt dat de verschillen tussen groepen echt geen toeval zijn, zouden ze misschien er beter op sturen en waarborgen inbouwen. Nu wordt per persoon bekeken of er sprake is van discriminatie, wat vaak lastig te bewijzen is. Maar iedereen weet dat het onzin is dat een hele raad van bestuur van een organisatie toevallig blanke oude man is (alleen bij HR was toevallig de beste kandidaat een vrouw). En datzelfde geldt voor alle andere vormen van discriminatie. Als de verschillen zo duidelijk zijn, zou je een organisatie verantwoordelijk moeten kunnen houden voor klaarblijkelijke discriminatie. Ik ben bang dat de stok het beter doet dan de wortel in deze omdat bias ingebakken zit in onze hersenen en het dus niet automatisch goed komt. Ik kijk uit naar de tijd dat we AI modellen nodig hebben om te kijken of er wordt gediscrimineerd.

Als een freelance AI consultant geef ik regelmatig workshops over verantwoord gebruik van AI. Omdat er in de media veel onzin verteld wordt over AI, krijg ik echt soms opmerkingen in de categorie ‘robots nemen de wereld over, ‘overbevolking van Mars’, ‘Neurale Netwerken snapt niemand’, moeten we dat wel willen, dat AI? Als je nadenkt over wat er allemaal mis kan gaan met een kettingzaag, lijkt het al snel logisch om het ding maar te verbieden. Maar de echte vraag is natuurlijk hoe het verantwoord gebruikt kan worden. Vooral in de politiek en in de media is het lekker om vraagstukken veel te ver te versimpelen tot schijnbare keuzes uit twee. De Corona app lijkt daar een voorbeeld van te worden: privacy of gezondheid. Gelukkig komt daar tegengas op door bij voorbeeld Arjen Lubach: het is én geen tegenstelling én niet de enige aspecten die belangrijk zijn. Eigenlijk zijn de vraagstukken voor AI hetzelfde als voor de Corona app. Beide zijn een systeem dat op basis van data conclusies trekt. Laat er nou voor AI goed werk verzet zijn om tot richtlijnen te komen voor verantwoord gebruik van data en modellen. Door zowel de EU High Level Expert Group on AI (b.v. door Catelijne Muller) als het World Economic Forum (b.v. Kay Firth-Butterfield). Het EU framework is 41 pagina’s, dus laat me het even samenvatten. Er zijn 7 dingen waar je op wilt letten: 1. Is het eerlijk: wordt iedereen gelijk behandeld 2. Is het betrouwbaar: blijft het systeem goed werken in bijzondere omstandigheden 3. Is de beveiliging zo dat de privacy gewaarborgd is 4. Is het transparant: is het duidelijk hoe het werkt 5. Is het duidelijk wie er verantwoordelijk is als het systeem niet goed werkt 6. Houd iemand overzicht: Kan er iemand het systeem overrulen 7. Is er aandacht voor de sociale impact, b.v. op de democratie Deze punten zijn allemaal belangrijk en moeten in samenhang beoordeeld worden. En zelfs als je het ok vindt om privacy op te geven, betekent dat nog niet dat je ok bent met een app als die vervolgens discrimineert, onduidelijk is welke regels gelden en je nergens in beroep kan als je het er niet mee eens bent. Het is niet alleen een ethische discussie, het is ook een legal discussie. Ongelijke behandeling mag niet, je moet je case kunnen voorleggen aan een rechter en het moet duidelijk zijn wie er aansprakelijk is op het goed functioneren van de app. Wetgeving is gestolde ethiek. Die kan je niet zomaar opzij zetten. Bij AI discussies wordt soms teveel nadruk gelegd op het type model dat gebruikt, in plaats van op de data die als input geldt. Als de ingrediënten niet deugen, kan je nog zoveel aandacht geven aan het recept, maar dan wordt het nooit een goede maaltijd. Bij de corona app gaat dat ongetwijfeld ook het geval zijn. Bij voorbeeld is de data die verzameld wordt een proxi van wat je wilt meten: je wilt meten of persoon A besmet kan zijn geworden door persoon B, maar je meet of de ene telefoon binnen bereik is geweest van een andere. Als je doet alsof dat hetzelfde is, komen er ongelukken (zie Weapons of math destruction van Cathy O'Neil) Dat de politiek het aan de bevolking over wil laten of en hoe een Corona app er uit gaat zien is nogal zorgelijk. Ik hoop dat ze het niet aan de bevolking over gaan laten om te bepalen of een vaccin werkt of niet.

People are biased, mainly, to make sense of a complex world with an overload of information and often little time to make a decision. It is not bad or good, we all do it to make it through the day. But it is important to be aware of this and don’t make our judgement ‘true’. Especially in the context of human versus AI decision making this is relevant. With the increasing use of Neural Networks in decision making, questions about model validity, especially about discrimination in models are raised more often. While this an important question, it is not so much the type of model that creates the risk of discrimination. Traditional statistical models basically always have had the same risk of discrimination as they are built on the same historical data. And the bias in that data is the result of all types of human bias in decision making in the past. So, if the question is raised whether an AI model discriminates, start with some soul searching how the input data is created. 50 suggestions are given here. That’s a good start for model builders not to automate human discrimination, even if the model is a simple if-then-else model. see https://www.visualcapitalist.com/50-cognitive-biases-in-the-modern-world/